この記事では,研究のサーベイをまとめていきたいと思います。ただし,全ての論文が網羅されている訳ではありません。また,分かりやすいように多少意訳した部分もあります。ですので,参考程度におさめていただければ幸いです。

間違えている箇所がございましたらご指摘ください。随時更新予定です。他のサーベイまとめ記事はコチラのページをご覧ください。

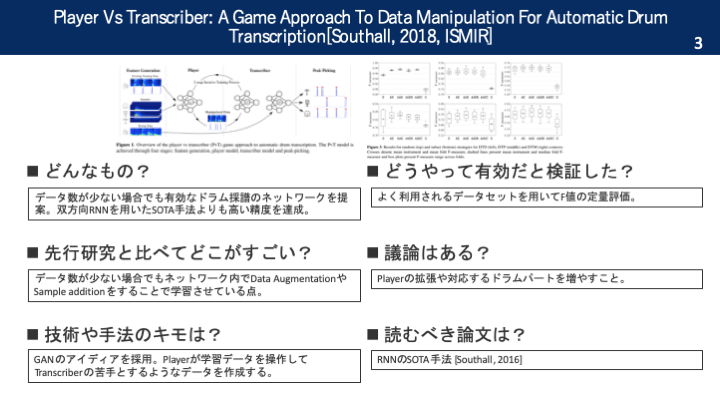

本論文を一枚の画像で

要旨

データ数が少ない場合でも有効なドラム採譜のネットワークを提案。双方向RNNを用いたSOTA手法よりも高い精度を達成。

導入

最新のサーベイ論文から分かる通り,SOTAを達成しているのはNMFとDNNに基づく方法。NMFは用途や目的に応じて様々な変形モデルが提案されている。DNNでは,最近畳み込みやsoft-attentionを利用したモデルが考案されている。しかし,従来のSOTAは教師あり学習で達成されている。応用を見据える上では,教師なし学習,もしくはデータせ数が少ない場合に対応できるネットワークを考案するべき。そこで,本論文ではGANを利用した「Player vs Transcriber」という構造のネットワークを提案する。

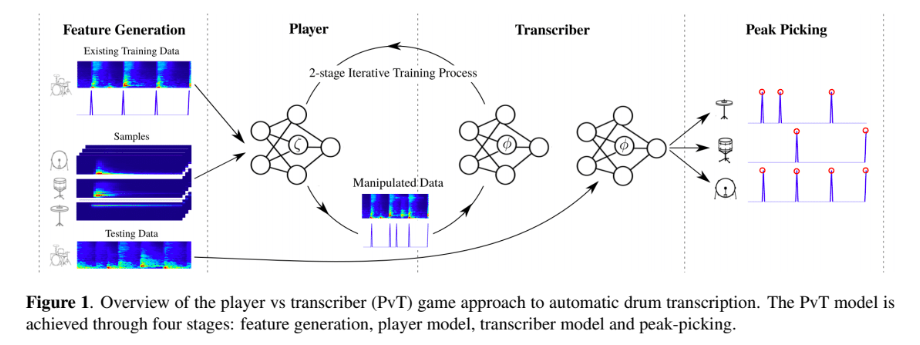

提案手法

基本的な流れは「特徴量抽出→Playerによるデータ操作→Transcriberによるアクティベーション抽出→ピークピッキング」となっている。特徴量はログスペクトログラムを使用。PlayerではTranscriberが苦手なデータを生成するように学習していく。Data AugmentationやSample additionを利用する。ネットワーク全体として誤差逆伝播できるように全ての操作を微分可能なものにする。Argmax等は使用しない。

今回Playerモデルは「Data Augmentationのみ(AE)」「Sample additionのみ(AAE)」「教師なし学習(G)」の三種類を作成。Transcriberモデルは[southall, 2016]の双方向RNNを利用したモデルを採用。PlayerはLossを最大化し,TranscriberはLossを最小化するように学習。TranscriberのLoss減少が少なくなったら学習ストップ。

実験

【データセット】

・DTD(drum transcription of drum-only recordings):IDMT-SMT-Drums dataset

・DTP(drumtranscription in the presence of percussion):ENST-Drumsmi-nus onesubse/MDB Drumsからdrum-only track

・DTM(drum transcription in the presence of melodic instruments):ENST-Drumsminus onesubset/MDB-Drums/RBMA-2013

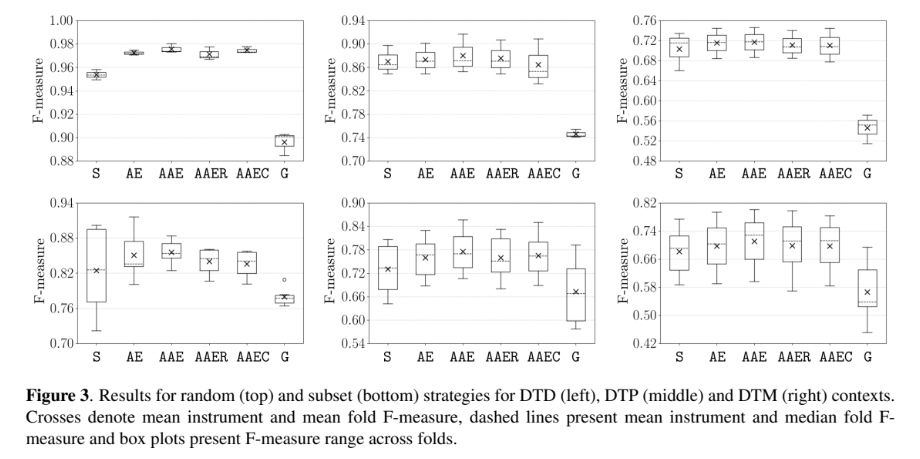

評価

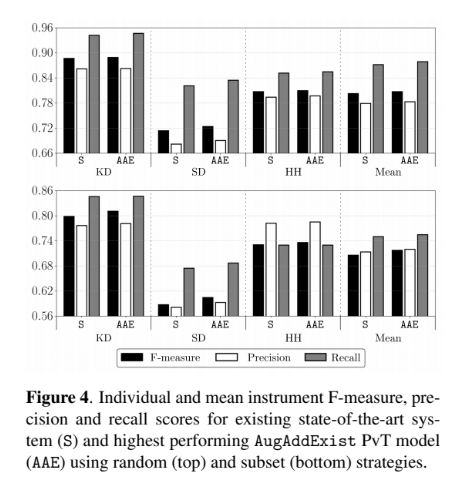

上段は全てのデータセットを3-分割交差検証,下段は学習とテストで異なるデータセットを使用した結果。Sは現在のSOTA(Transcriberのみ)。結果としては,AEとAAEはSより精度が高かった。Gが低いのは教師なし学習を行なっているため。

上段と下段の対応は同じ。パートごとのF値を示したもの。相変わらずSDの精度は低いものの,Sより若干の改善が見られる。

今後の課題

Playerもでるで既存のパターンではなく新規パターンを作ること。より多くのドラムパートに対応させること。

まとめ

データ数が少ない場合に強力なネットワークの提案でした。

Southall, Carl, Ryan Stables, and Jason Hockman. “Player Vs Transcriber: A Game Approach To Data Manipulation For Automatic Drum Transcription.” ISMIR. 2018.