この記事では,研究のサーベイをまとめていきたいと思います。ただし,全ての論文が網羅されている訳ではありません。また,分かりやすいように多少意訳した部分もあります。ですので,参考程度におさめていただければ幸いです。

間違えている箇所がございましたらご指摘ください。随時更新予定です。他のサーベイまとめ記事はコチラのページをご覧ください。

本論文を一枚の画像で

要旨

従来のRNNに基づくドラム採譜のモデルは主要3パートで評価されており,ポリフォニック信号に対してはあまり精度は出ていない。そこで,本研究では新たに2つのモデルを提案する。結果として,5つの評価シナリオにおいてSOTAを達成した。実は,ドラム採譜に初めてCNNを適用した研究でもある。

提案手法

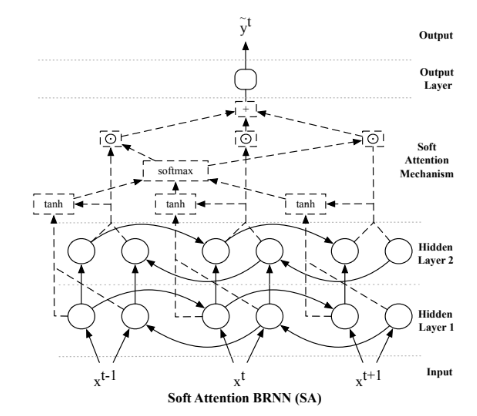

Soft-attentionとは,隠れ状態の重要度を確率値で表す変数を導入したネットワーク構造。ちなみに,Hard-attentionは「重要度に基づく重みつき平均」を利用するのではなく「重要度に基づく確率的な決定」を利用する。つまり,soft-attentionでは隠れ状態は与えられた重要度だけモデルに寄与する。一方,hard-attentionは隠れ状態が与えられた重要度の確率値で選ばれる。隠れ層にはpeephole付きのLSTMを使用。

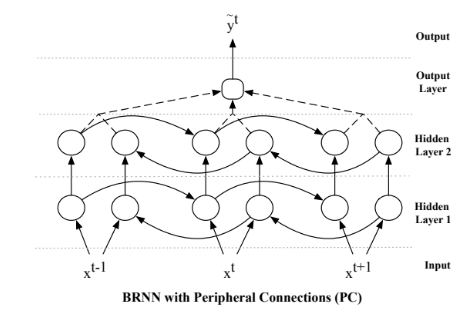

隠れ状態間に結合を持たせたネットワーク。隠れ層でLSTMを使いながらうまく伝達させていこうというアイディア。

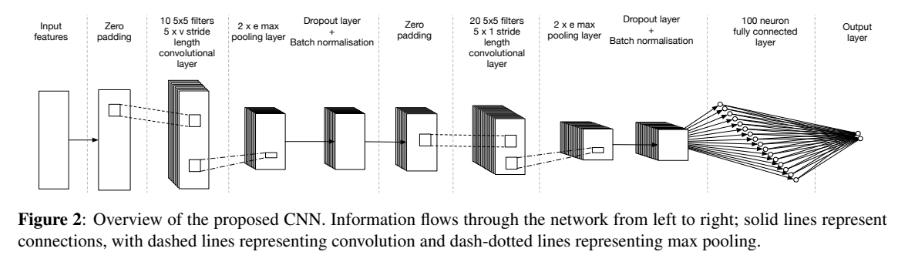

Onset ditectionやDownbeat detectionでよい性能を示しているCNNを導入してみようというモチベーション。

実験・評価

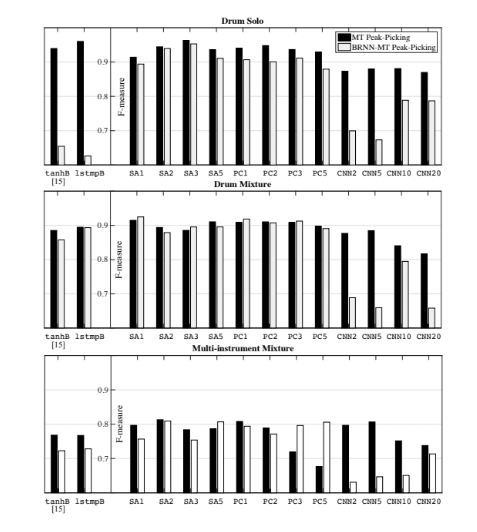

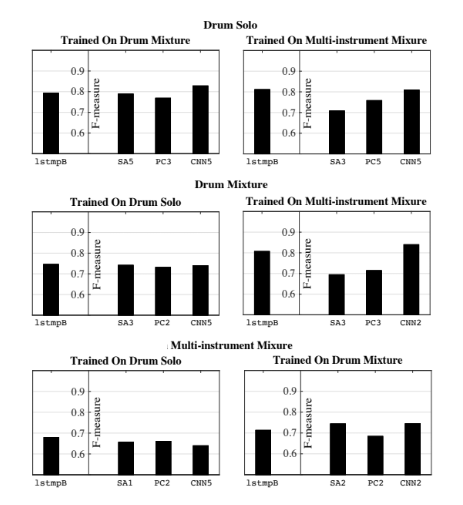

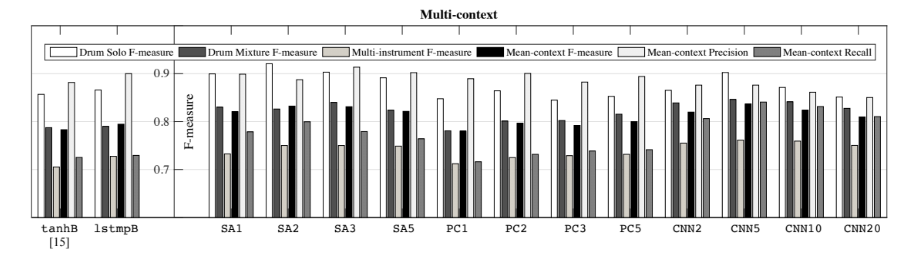

「Drum Solo」はIDMT-SMTデータセットを利用。「Drum Mixture」「Multi-instrument Mixture」はENSTデータセットを利用。これらは「Singe-context」といえる。一方,「Cross-context」は異なるタスク間で評価し,「Multi-context」は異なるタスクをごちゃ混ぜにして学習・テスト。SAの後の数字はattentionする範囲,PCの後の数字は周辺結合する範囲,CNNの後の数字は畳み込みの時間方向の幅。

結論

SAとPCは隠れ状態のtime-step間の情報をうまく保持できる。CNNは大きなInputに対応できる。複雑なタスクほど提案手法は有効。つまり,多くの情報を活用できるモデルということ。タスクが決まっている場合はSAが性能が良く,決まっていない場合はCNNが性能が良い。

まとめ

Soft-attentionを利用したドラム採譜の研究でした。

Southall, Carl, Ryan Stables, and Jason Hockman. “Automatic Drum Transcription for Polyphonic Recordings Using Soft Attention Mechanisms and Convolutional Neural Networks.” ISMIR. 2017.